三只1C1G小鸡跑分对比

经过我多年潜心研究揭露出一个真相:仅仅一只1C1G小鸡就能满足我的所有要求了。扎心。。。

蚊子肉也是肉,1C1G也是鸡,基于此,我特地找了手里三只1C1G的小鸡来对比下。

- 有钱就是爷,即使只1o,也比免费好。但NetCup低价机超售也确实太狠了,300多分的GB5,但谁也没想把1o的机器的CPU往死里跑吧。4K一般,不重度使用应该没问题。 (我用超售而不是限制的字眼,是因为IO和CPU跑分波动很大,而限制的话分应该很稳定)

- 甲骨文在三者居中。CPU免费的能有1o的水平让我很意外。4K凑合,一般的应用应该不卡。甲骨文主要问题就在于是玄学封号,不过,我始终认为,没有玄学,只有滥用。就算是冤枉的,也只是因为用户行为与滥用近似被误伤。

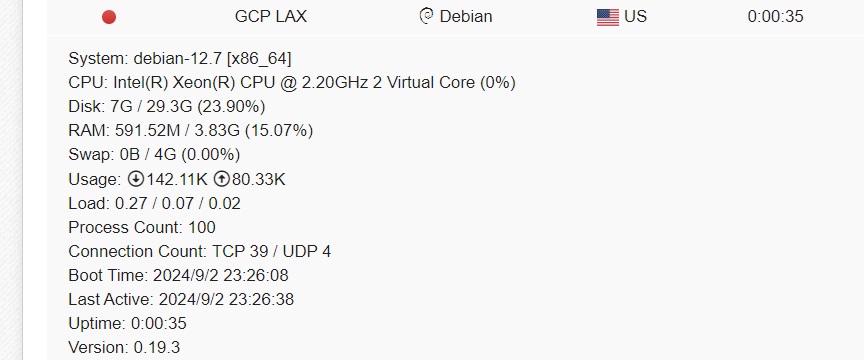

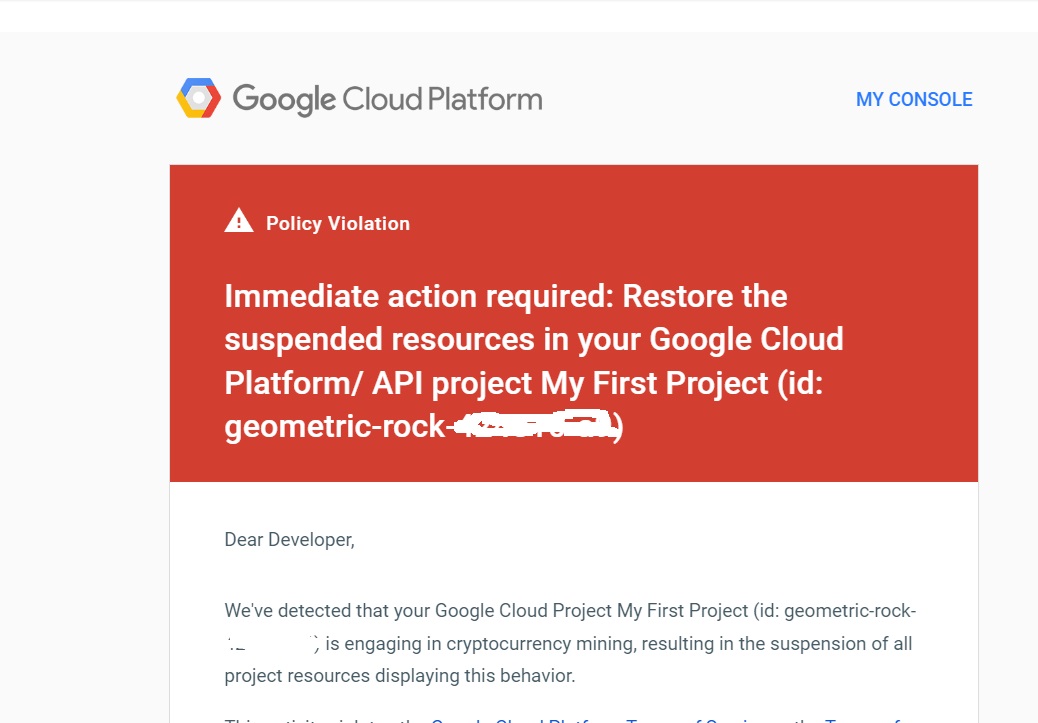

- GCP只能供着。4K IO属于打个 ls 都要卡一下的级别,然后在CPU高占用下可能是积分制会迅速限制性能。当然,还有祖传的潜在反撸的可能。但gcp的好处是,如果不滥用不欠费,很稳,跑跑小业务,比如低频后端api还是可以的。

网络就不扯了,三家的网络国际都很好,对中国当然都一塌糊涂。这个谁都知道。

NetCup 1o

ISP : netcup GmbH

ASN : AS197540 netcup GmbH

Host : NETCUP-GMBH

Location : Nuremberg, Bavaria (BY)

Country : Germany

fio Disk Speed Tests (Mixed R/W 50/50) (Partition /dev/vda3):

---------------------------------

Block Size | 4k (IOPS) | 64k (IOPS)

------ | --- ---- | ---- ----

Read | 37.45 MB/s (9.3k) | 527.12 MB/s (8.2k)

Write | 37.54 MB/s (9.3k) | 529.90 MB/s (8.2k)

Total | 75.00 MB/s (18.7k) | 1.05 GB/s (16.5k)

| |

Block Size | 512k (IOPS) | 1m (IOPS)

------ | --- ---- | ---- ----

Read | 725.19 MB/s (1.4k) | 788.18 MB/s (769)

Write | 763.72 MB/s (1.4k) | 840.67 MB/s (820)

Total | 1.48 GB/s (2.9k) | 1.62 GB/s (1.5k)

Geekbench 5 Benchmark Test:

---------------------------------

Test | Value

|

Single Core | 377

Multi Core | 365 Oracle 免费AMD

ISP : Oracle Corporation

ASN : AS31898 Oracle Corporation

Host : Oracle Cloud Infrastructure (ap-tokyo-1)

Location : Tokyo, Tokyo (13)

Country : Japan

fio Disk Speed Tests (Mixed R/W 50/50) (Partition /dev/sda2):

---------------------------------

Block Size | 4k (IOPS) | 64k (IOPS)

------ | --- ---- | ---- ----

Read | 6.37 MB/s (1.5k) | 26.46 MB/s (413)

Write | 6.37 MB/s (1.5k) | 26.97 MB/s (421)

Total | 12.74 MB/s (3.1k) | 53.44 MB/s (834)

| |

Block Size | 512k (IOPS) | 1m (IOPS)

------ | --- ---- | ---- ----

Read | 24.50 MB/s (47) | 24.17 MB/s (23)

Write | 26.01 MB/s (50) | 26.68 MB/s (26)

Total | 50.51 MB/s (97) | 50.85 MB/s (49)

Geekbench 5 Benchmark Test:

---------------------------------

Test | Value

|

Single Core | 336

Multi Core | 310 Google Cloud 免费E2-Micro

ISP : Google LLC

ASN : AS15169 Google LLC

Host : Google Cloud (us-west1)

Location : The Dalles, Oregon (OR)

Country : United States

fio Disk Speed Tests (Mixed R/W 50/50) (Partition /dev/sda1):

---------------------------------

Block Size | 4k (IOPS) | 64k (IOPS)

------ | --- ---- | ---- ----

Read | 406.00 KB/s (101) | 5.79 MB/s (90)

Write | 428.00 KB/s (107) | 6.09 MB/s (95)

Total | 834.00 KB/s (208) | 11.89 MB/s (185)

| |

Block Size | 512k (IOPS) | 1m (IOPS)

------ | --- ---- | ---- ----

Read | 27.53 MB/s (53) | 37.68 MB/s (36)

Write | 29.45 MB/s (57) | 40.94 MB/s (39)

Total | 56.98 MB/s (110) | 78.62 MB/s (75)

Geekbench 5 Benchmark Test:

---------------------------------

Test | Value

|

Single Core | 475

Multi Core | 99